炒股就看金麒麟分析师研报,权威,专业,及时,全面,助您挖掘潜力主题机会!

(来源:机器之心Pro)

机器之心编辑部

新年第一天,DeepSeek发布了一篇新论文,提出了一种名为mHC(流形约束超连接)的新架构。

该研究旨在解决传统超连接在大规模模型训练中的不稳定性问题,同时保持其显著的性能增益。

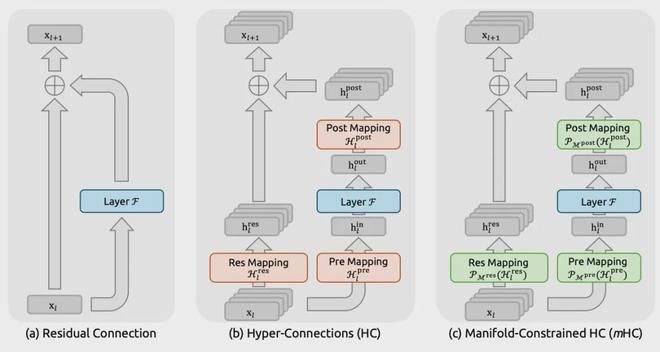

简单来说,DeepSeek提出的mHC通过将传统Transformer的单一残差流扩展为多流并行架构,并利用Sinkhorn-Knopp算法将连接矩阵约束在双拟随机矩阵流形上,成功解决了超连接(HC)在大规模训练中因破坏恒等映射属性而导致的数值不稳定和信号爆炸问题。

这篇论文的第一作者有三位:ZhendaXie(解振达)、YixuanWei(韦毅轩)、HuanqiCao。值得注意的是,DeepSeek创始人&CEO梁文锋也在作者名单中。

传统的残差连接(即Transformer中的x+F(x)结构)凭借「恒等映射」保证了信号无损传输和训练稳定性。但它的瓶颈在于信息通道的宽度受限于隐藏层维度C。

近期,以字节跳动Seed团队提出的Hyper-Connections(HC)为代表的研究,通过扩展残差流宽度和多样化连接模式,拓展了过去十年中广泛应用的残差连接范式。

虽然这些方法带来了显著的性能提升,但但也带来了两个严重问题:

从根本上破坏了残差连接固有的恒等映射属性,导致了严重的训练不稳定性和受限的可扩展性,并额外增加了显著的内存访问开销。

为了解决这些挑战,DeepSeek的研究团队提出了Manifold-ConstrainedHyper-Connections(mHC,流形约束超连接)。

这是一个通用框架,它将HC的残差连接空间投影到一个特定的流形上,以恢复恒等映射属性,同时结合严格的基础设施优化以确保效率。

它的核心目的是:在保留「加宽残差流」带来的性能提升的同时,解决其导致的训练不稳定和显存消耗过大的问题。

团队利用Sinkhorn-Knopp算法将残差连接矩阵投影到Birkhoff多胞形(双随机矩阵)上。这使得信号传播变为特征的「凸组合」,从数学上严格保证了信号范数的稳定性(能量守恒)。为了抵消加宽通道带来的开销,团队实施了内核融合、选择性重计算以及扩展的DualPipe通信计算重叠策略。

实证表明,mHC不仅解决了稳定性问题,且在大规模训练中(如27B模型)表现出卓越的可扩展性。在n=4的扩展倍率下,仅增加了6.7%的训练时间开销,却换来了显著的性能提升。mHC为基础模型的拓扑架构演进指明了方向。

图1:残差连接范式示意图。本图对比了以下三种结构设计:(a)标准残差连接(ResidualConnection);(b)Hyper-Connections(HC);(c)我们提出的Manifold-ConstrainedHyper-Connections(mHC)。与无约束的HC不同,mHC专注于优化残差连接空间,通过将矩阵投影到受约束的流形上,以确保稳定性。

具体方法介绍

流形约束超连接(mHC)

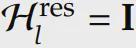

借鉴恒等映射(IdentityMapping)原则,mHC的核心前提是将残差映射

虽然原始的恒等映射是通过强制执行

因此,该DeepSeek团队提出将残差映射投影到一个流形上,既能保持跨层信号传播的稳定性,又能促进残差流之间的相互作用,以保持模型的表达能力(expressivity)。

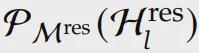

为此,他们的做法是将

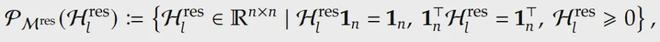

形式上,令

其中1_n表示全1的n维向量。

为什么选择双拟随机性?因为其具有多项有利于大规模训练的理论属性:

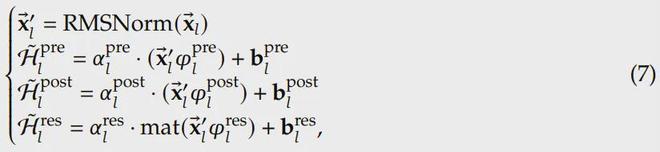

此外,该团队还对输入映射

参数化与流形投影

本节将详述mHC中各映射的计算过程。

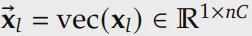

给定第l层的输入隐藏矩阵x_l,先将其展平为向量

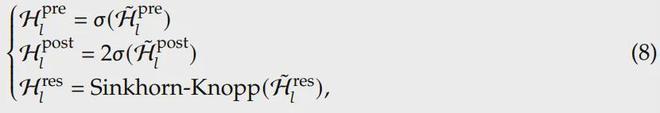

最终的约束映射通过以下方式获得:

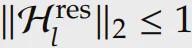

其中

DeepSeek在实验中采用t_max=20次迭代。

高效基础设施设计

DeepSeek还为mHC量身定制了基础设施设计,使其在n=4时在大模型中的训练开销仅增加6.7%:

算子融合(KernelFusion):

重新调整RMSNorm的顺序以提高效率,并采用混合精度策略。

开发了统一的算子,将多次扫描和矩阵乘法融合,减少内存带宽瓶颈和算子启动开销。

在单个算子中实现Sinkhorn-Knopp迭代及其自定义反向传播。

重计算(Recomputing):

为了减轻n流设计带来的内存压力,DeepSeek在前向传播后丢弃mHC算子的中间激活,并在反向传播时即时重新计算。

通过推导得出最优重计算块大小L_r^*,以最小化总内存占用。

DualPipe中的通信重叠:

扩展了DualPipe调度算法,以改善流水线并行阶段边界处的通信与计算重叠在专用高优先级计算流上执行MLP层的内核,并避免在注意力层使用持久算子,以防止阻塞通信流并提高设备利用率。

实验

实验设置

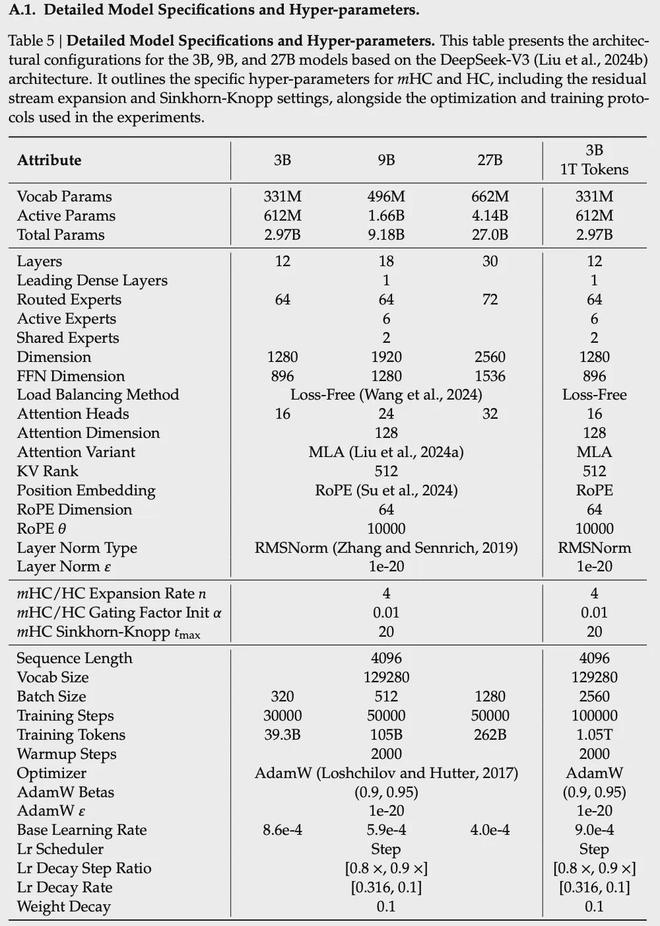

研究团队通过语言模型预训练来验证所提方法的有效性,并对基线模型、超连接(HC)以及提出的流形约束超连接(mHC)进行了对比分析。

他们采用了受DeepSeek-V3启发的MoE架构,训练了四种不同的模型变体,以覆盖不同的评估体系。

具体而言,HC和mHC的扩展率n均设置为4,主要关注点是一个27B参数规模的模型。其训练数据集的大小与其参数量成正比,该模型用于展示系统层面的主要结果。在此基础上,他们通过引入使用成比例数据训练的较小的3B和9B模型来分析计算扩展性,从而观察不同计算规模下的性能趋势。此外,为了专门研究Token规模的影响,他们另外训练了一个独立的3B模型,该模型在一个固定的1TToken的语料库上进行训练。

主要结果

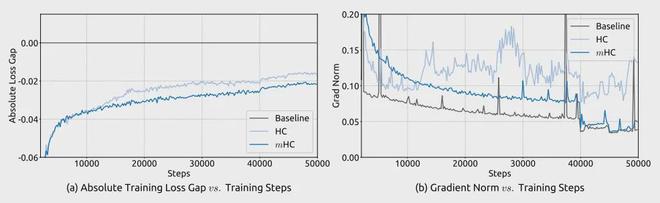

图5:流形约束超连接(mHC)的训练稳定性。该图展示了:(a)mHC和HC相对于基线模型的训练损失绝对差值;(b)三种方法在训练过程中的梯度范数。所有实验均基于27B参数规模的模型。实验结果表明,mHC在损失函数和梯度范数两方面均表现出更优的稳定性。

研究团队首先考察27B模型的训练稳定性和收敛性。如图5(a)所示,mHC有效缓解了在HC中观察到的训练不稳定问题,与基线模型相比,最终损失降低了0.021。图5(b)中的梯度范数分析进一步证实了这种稳定性的提升:mHC表现出明显优于HC的行为,保持了与基线模型相当的稳定轮廓。

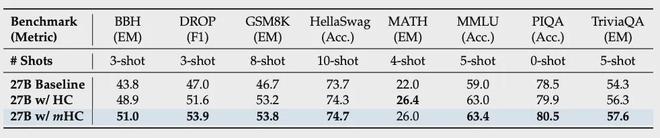

表4:27B模型在系统级基准测试上的结果。本表对比了基线模型、HC以及mHC在8个不同的下游基准测试中的零样本和少样本性能表现。结果显示,mHC始终优于基线模型,并在大多数基准测试中超越了HC,证明了其在大规模预训练中的有效性。

表4展示了在多种下游基准测试中的性能表现。mHC带来了全面的提升,一致性地优于基线模型,并在大多数任务上超过了HC。值得注意的是,与HC相比,mHC进一步增强了模型的推理能力,在BBH和DROP任务上分别实现了2.1%和2.3%的性能增益。

规模扩展实验

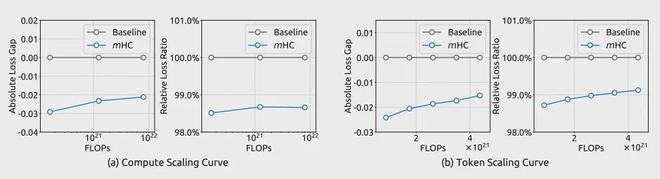

图6:mHC与基线模型的扩展特性对比。(a)计算扩展曲线:实线描绘了在不同计算预算下的性能差距。每个点代表模型大小与数据集大小的最优计算配置,涵盖了从3B、9B到27B参数规模的规模扩展过程。(b)Token扩展曲线:展示了3B模型在训练过程中的轨迹。每个点代表模型在不同训练Token数量下的性能表现。

为了评估该方法的扩展性,研究者报告了在不同规模下mHC相对于基线模型的损失改善情况。在图6(a)中,他们绘制了涵盖3B、9B和27B参数规模的计算规模扩展曲线。其轨迹表明,即使在更高的计算预算下,性能优势依然稳健地得以保持,仅表现出轻微的衰减。

此外,他们在图6(b)中考察了训练过程中的动态变化,展示了3B模型的Token扩展曲线。总的来看,这些发现验证了mHC在大规模场景下的有效性。这一结论在他们内部的大规模训练实验中得到了进一步的证实。

更多详情请参阅原论文。

海量资讯、精准解读,尽在新浪财经APP

海量资讯、精准解读,尽在新浪财经APP 编辑: 来源: